सरकार का निर्देश- शिकायत के बाद 36 घंटे में डीपफेक से जुड़े फोटोज और वीडियोज को हटाने का निर्देश

डीपफेक एडिटेड वीडियो – एक चेहरे को अन्य चेहरे से बदल दिया जाता है, जिसमें आईपीसी की धाराओं में कार्यवाही जुर्माना है-एडवोकेट किशन सनमुखदास भावनानी, गोंदिया

किशन सनमुखदास भावनानी, गोंदिया, महाराष्ट्र। वैश्विक स्तर पर आधुनिक प्रौद्योगिकी आर्टिफिशियल इंजीनियरिंग, मशीन लर्निंग और डिजिटाइजेशन की पैर पसारती प्रगति ने जहां एक और अति सुख सुविधा समृद्धि उपलब्ध कराई है तो दूसरी ओर इसके अनेकों निष्ठुर, दुराचारी, आर्थिक कमरतोड़ और समाज जाति में बढ़ती अश्लीलता को प्रोत्साहित कर रहे हैं बीते कुछ समय से डीपफेक मामलों के बढ़ते दुरुपयोग की गति से भारत सहित पूरी दुनियां चिंताजनक है। इसके बढ़ते दुरुपयोग से माननीय प्रधानमंत्री सहित केंद्रीय आईटी मंत्री ने संज्ञान लिया है। इसका दुरुपयोग करने वाले को आईपीसी अधिनियम के अंतर्गत सटीक कार्यवाही और जुर्माने की बात कही गई है चूंकि इस कृत्य से समाज में दूषित वातावरण पनपता है। इसलिए आज हम मीडिया में उपलब्ध जानकारी के सहयोग से इस आर्टिकल के माध्यम से चर्चा करेंगे, सरकार के निर्देश, 36 घंटे में डीपफेक से जुड़े फोटोस और वीडियोज को हटाने का आदेश।

साथियों बात अगर हम डीपफेक को समझने की करें तो किसी रियल वीडियो में दूसरे के चेहरे को फिट कर देने को डीपफेक नाम दिया गया है, जिसे हम लोग यकीन मान लें। डीपफेक से वीडियो और फोटो को बनाया जाता है। इसमें मशीन लर्निंग और आर्टिफिशियल इंटेलिजेंस का सहारा लिया जाता है। इसमें वीडियो और ऑडियो को टेक्नोलॉजी और सॉफ्टवेयर की मदद से बनाया जाता है। इसी डीपफेक से वीडियो बनाया जाता है। साधारण शब्दों में समझें, तो इस टेक्नोलॉजी में कोडर और डिकोडर टेक्नोलॉजी की मदद ली जाती है। डिकोडर सबसे पहले किसी इंसान के चेहरे को हावभाव और बनावट की गहन जांच करता है। इसके बाद किसी फर्जी फेस पर इसे लगाया जाता है, जिससे हुबहू फर्जी वीडियो और फोटो को बनाया जा सकता है।

हालांकि इसे बनाने में काफी टेक्नोलॉजी की जरूरत होती है, ऐसे में आम लोग डीपफेक वीडियो नहीं बना सकते हैं। लेकिन इन दिनों डीपफेक बनाने से जुड़े ऐप मार्केट में मौजूद हैं, जिनकी मदद से आसानी से डीफफेक वीडियो को बनाया जा सकता है। बहुत ही आसान भाषा में कहें तो डीपफेक एक एडिटेड वीडियो होता है जिसमें किसी अन्य के चेहरे को किसी अन्य के चेहरे से बदल दिया जाता है। डीपफेक वीडियोज इतने सटीक होते हैं कि हम इन्हें आसानी से पहचान नहीं सकते। ताजा उदाहरण के लिए हम रश्मिका मंदाना के वीडियो को देख सकते हैं। यदि जारा पटेल का असली वीडियो सामने नहीं आता तो कोई भी यकीन कर लेता है कि यह वीडियो रश्मिका का ही है। किसी भी इंसान का डीपफेक वीडियो बनाया जा सकता है। डीपफेक वीडियो बनाने के लिए आर्टिफिशियल इंटेलिजेंस और मशीन लर्निंग की भी मदद ली जाती है।

साथियों बात अगर हम डीपफेक वीडियो बनाने की सजा की करें तो, यदि हम मजाक में किसी का डीपफेक वीडियोज बनाते हैं और शेयर करते हैं तो हमारे खिलाफ आईपीसी की धारा के तहत कार्रवाई हो सकती है। भारी जुर्माना भी लगाया जा सकता है। इसके अलावा यदि किसी की छवि खराब होती है तो आपके खिलाफ मानहानी का भी मामला बनेगा। इस मामले में सोशल मीडिया कंपनियों के खिलाफ भी आईटी नियमों के तहत कार्रवाई हो सकती है। शिकायत के बाद 36 घंटे के अंदर सोशल मीडिया कंपनियों को अपने प्लेटफॉर्म से इस तरह के कंटेंट को हटाना होगा। सरकार भी डीपफेक को लेकर सतर्क है। सरकार की की तरफ से सोशल मीडिया प्लेटफॉर्म से डीपफेक से जुड़े फोटो और वीडियो को हटाने का निर्देश दिया है। सरकार के निर्देश के मुताबिक सभी प्लेटपऑर्म से 36 घंटों में डीपफेक से जुड़े फोटो और वीडियो को हटाने का निर्देश दिया गया है। डीपफेक वीडियो को फेशियल एक्सप्रेशन से पहचाना जा सकता है।फोटो और वीडियो के आईब्रो, लिप्स को देखकर और उसके मूवमेंट से भी पहचान की जा सकती है।

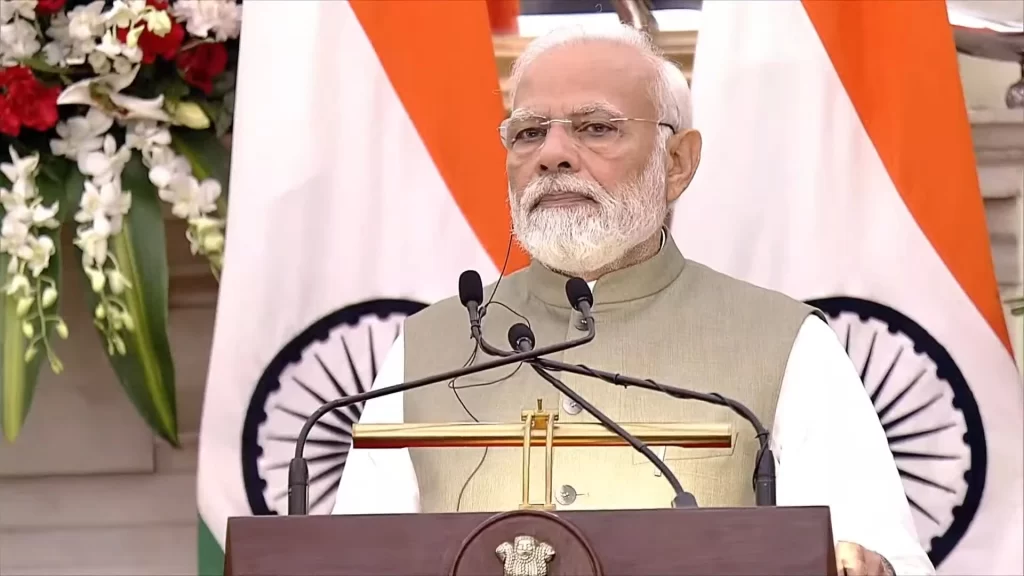

साथियों बात कर हम डीपफेक के संबंध में माननीय पीएम के विचारों की करें तो, उन्होंने शुक्रवार को कहा था कि कृत्रिम मेधा (एआई) का इस्तेमाल ‘डीप फेक’ बनाने के लिए किया जाना चिंताजनक है। साथ ही उन्होंने मीडिया से इसके दुरुपयोग और प्रभाव के बारे में जागरूकता फैलाने का आग्रह किया था। दिवाली मिलन कार्यक्रम में पत्रकारों को संबोधित करते हुए पीएम ने कहा कि उन्होंने गरबा महोत्सव में गाते हुए अपना एक वीडियो देखा, जबकि उन्होंने स्कूल के दिनों से ऐसा नहीं किया है। उन्होंने मजाकिया लहजे में कहा, यहां तक कि जो लोग उन्हें प्यार करते हैं, वे भी वीडियो को एक दूसरे से साझा कर रहे हैं। उन्होंने कहा, हमारे जैसे विविधता पूर्ण समाज में डीप फेक एक बड़ा संकट पैदा कर सकते हैं और यहां तक कि समाज में असंतोष की आग भी भड़का सकते हैं क्योंकि लोग मीडिया से जुड़ी किसी भी चीज पर उसी तरह भरोसा करते हैं जैसे आम तौर पर गेरुआ वस्त्र पहने व्यक्ति को सम्मान देते हैं। इसी डीपफेक से वीडियो बनाया जाता है। साधारण शब्दों में समझें तो इस टेक्नोलॉजी कोडर और डिकोडर टेक्नोलॉजी की मदद ली जाती है। डिकोडर सबसे पहले किसी इंसान के चेहरे को हावभाव और बनावट की गहन जांच करता है। इसके बाद किसी फर्जी फेस पर इसे लगाया जाता है, जिससे हुबहू फर्जी वीडियो और फोटो को बनाया जा सकता है।

उन्होंने कहा, कृत्रिम मेधा के माध्यम से उत्पादित डीप फेक के कारण एक नया संकट उभर रहा है। समाज का एक बहुत बड़ा वर्ग है जिसके पास समानांतर सत्यापन प्रणाली नहीं है। पीएम ने कार्यक्रम में पत्रकारों से कहा कि जहां उन्होंने कुछ चीजों के बारे में विचार व्यक्त किए हैं वहीं उन्हें इस बारे में जागरुकता फैलाने के लिए मीडिया का सहयोग चाहिए। डीप फेक तकनीक शक्तिशाली कंप्यूटर और शिक्षा का उपयोग करके वीडियो, छवियों, ऑडियो में हेरफेर करने की एक विधि है। पीएम ने कहा कि पहले कुछ विवादास्पद टिप्पणियों वाली फिल्म आती थी और चली जाती थीं, लेकिन अब यह एक बड़ा मुद्दा बन गया है। उन्होंने कहा कि ऐसी फिल्मों का प्रदर्शन भी इस आधार पर मुश्किल हो जाता है कि उन्होंने समाज के कुछ तबकों का अपमान किया है, भले ही उन्हें बनाने में भारी राशि खर्च की गई हो। उन्होंने सुझाव दिया कि जिस तरह सिगरेट जैसे उत्पाद स्वास्थ्य संबंधी चेतावनियों के साथ आते हैं, उसी तरह डीप फेक के मामलों में भी होना चाहिए।

साथियों बात अगर हम केंद्रीय आईटी मंत्री द्वारा सोशल मीडिया प्लेटफॉर्म को चेतावनी देने की करें तो उन्होंने शनिवार को सोशल मीडिया प्लेटफार्मों को चेतावनी दी कि सूचना और प्रौद्योगिकी अधिनियम में सुरक्षित बंदरगाह खंड के तहत उन्हें जो छूट प्राप्त है, वह लागू नहीं होगी यदि वे डीपफेक को हटाने के लिए कदम नहीं उठाते हैं। धारा के अनुसार, किसी ऑनलाइन प्लेटफॉर्म को उपयोगकर्ताओं द्वारा उस पर पोस्ट की गई सामग्री के लिए जिम्मेदार नहीं ठहराया जा सकता है। केंद्रीय मंत्री ने कहा कि केंद्र सरकार ने हाल ही में सभी बड़े सोशल मीडिया प्लेटफॉर्म को नोटिस जारी किया है और उनसे डीपफेक की पहचान करने और सामग्री को हटाने के लिए कदम उठाने को कहा है। उन्होंने कहा कि प्लेटफार्मों ने प्रतिक्रिया दी और वे कार्रवाई कर रहे हैं। उन्होंने कहा कि लेकिन हमने उन्हें इस काम में और अधिक आक्रामक होने के लिए कहा है। प्रधानमंत्री नरेंद्र मोदी ने कहा कि डीपफेक सबसे बड़े खतरों में से एक है जिसका भारतीय प्रणाली इस समय सामना कर रही है और इसमें समाज में अराजकता पैदा करने की क्षमता है। हाल ही में काजोल, कैटरीना कैफ और रश्मिका मंदाना समेत कई बॉलीवुड कलाकार डीपफेक वीडियो का निशाना बने। डीपफेक तकनीक उपयोगकर्ताओं को मशीन लर्निंग और कृत्रिम बुद्धिमत्ता का उपयोग करके किसी छवि या वीडियो को संशोधित करने की अनुमति देती है। यह तकनीक वीडियो या ऑडियो रिकॉर्डिंग में किसी व्यक्ति की उपस्थिति और आवाज में हेरफेर कर सकती है, जिससे प्रामाणिक और हेरफेर की गई सामग्री के बीच अंतर करना चुनौतीपूर्ण हो जाता है।

अतः अगर हम उपरोक्त पूरे विवरण का अध्ययन कर इसका विश्लेषण करें तो हम पाएंगे कि डीपफेक – सबसे बड़े खतरों में से एक – समाज में अराजकता पैदा करने की क्षमता रखता है। सरकार का निर्देश -शिकायत के बाद 36 घंटे में डीपफेक से जुड़े फोटोज और वीडियोज को हटाने का निर्देश। डीपफेक एडिटेड वीडियो – एक चेहरे को अन्य चेहरे से बदल दिया जाता है, जिसमें आईपीसी की धाराओं में कार्यवाही जुर्माना है।